Sicherheitsteams haben zunehmend Fragen zur generativen KI, da sie in rasantem Tempo in viele Software-as-a-Service (SaaS)-Lösungen und Cloud-Plattformen integriert wird.

Trotz der Leistungsfähigkeit der KI, die Produktivität von Unternehmen zu steigern, wägen die Führungskräfte die Kosten der damit verbundenen Sicherheitsrisiken ab. Die Sicherung von sensitiven Daten, auf die KI zugreift, hat natürlich ebenfalls hohe Priorität, und Unternehmen versuchen, GenAI-Tools sicher zu aktivieren und einen langfristigen Lebenszyklusplan zu erstellen.

Durch mehrere Webinare, Kundenkontakte, CISO-Roundtables und Risikobewertungen, die bei Varonis durchgeführt werden, helfen wir, viele häufig gestellte Fragen zu KI und den Sicherheitsrisiken ihres Einsatzes in Unternehmen zu beantworten. Dieser Blogbeitrag ist eine Zusammenstellung der wichtigsten Fragen und Antworten aus diesen Interaktionen.

Mit den Antworten auf die wichtigsten Fragen zur KI-Sicherheit können Sie selbstbewusst organisatorische Entscheidungen über KI treffen und spezifische Pläne und Strategien aufdecken, die Sie berücksichtigen sollten. Sehen wir es uns im Detail an.

Allgemeine Fragen zur KI-Sicherheit

#1 Was ist KI-Sicherheit?

Je nach Ihrer Definition von KI kann die Sicherheit von KI unterschiedliche Bedeutungen haben.

KI-Sicherheit kann sich auf den Schutz von Informationen vor KI-Tools wie großen Sprachmodellen (LLMs) beziehen. Organisationen möchten verwalten, auf welche Daten zugegriffen wird, sich vor Missbrauch schützen und Bedrohungen wie Jailbreaking oder Datenvergiftung überwachen. Eine Komponente der KI-Sicherheit in diesem Sinne kann die Verhinderung von Schatten-KI umfassen.

KI-Sicherheit umfasst auch die Nutzung von KI, um die Sicherheitslage eines Unternehmens zu verbessern. Die Implementierung von KI-gestützter Cyber-Security kann Organisationen dabei unterstützen, Cyberangriffe und Datenlecks zu bekämpfen, die Sanierungsmaßnahmen zu optimieren und die Erkennungszeit zu verkürzen.

Da die Einführung von KI immer schneller voranschreitet, müssen Unternehmen vollständige Transparenz und Kontrolle über KI-Tools und -Workloads haben. Dies unterstreicht, dass die KI-Sicherheit ein wesentlicher Bestandteil der Datensicherheit ist. Eine ordnungsgemäße KI-Sicherheit unterstützt Organisationen dabei, Werkzeuge sicher zu implementieren und das Risiko des Lecks sensibler Informationen zu bekämpfen.

#2 Sollten wir nicht warten, bis die KI weiter ausgereift ist, bevor wir uns darauf einlassen?

Unsere Welt wird nicht in die Zeit vor der KI zurückkehren. Wenn Sie also nicht bereits darüber nachdenken, wie Sie sie in Ihr Unternehmen integrieren oder wie sie funktioniert, werden Sie auf lange Sicht hinterherhinken.

Ein weiteres erhebliches Risiko, dem Organisationen zunehmend ausgesetzt sind, ist Schatten-KI, bei der Benutzer nicht genehmigte KI-Anwendungen herunterladen und verwenden, weil ihre zentrale IT-Organisation ihnen keine entsprechende Option bietet. Ein aktuelles Beispiel für diesen Trend sind die rasant steigenden Downloads von DeepSeek.

Wir empfehlen Ihnen jedoch nicht, KI-Tools in Ihrer Organisation zu aktivieren, ohne sich vorher gründlich darüber zu informieren. Es ist wichtig, alle Vorteile und Risiken zu verstehen und zu wissen, wie einige Lösungen die Daten verwenden, die Sie in sie eingeben, um sicherzustellen, dass Sie kritische Informationen vor der Bereitstellung richtig schützen können.

„In vielerlei Hinsicht stellen KI und generative KI eine Gelegenheit dar, im Bereich der Sicherheit mit gutem Beispiel voranzugehen und anderen tatsächlich zu zeigen, wie es einen Nutzen gibt“, sagte Matt Radolec, VP of Incident Response and Cloud Operations bei Varonis, während eines Webinars mit CISOs und anderen Branchenführern zu diesem Thema. „Es gibt einen ROI durch die Nutzung dieser Tools, und sie sind sicher.“

#3 Welche Ressourcen stehen für diejenigen zur Verfügung, die ihre KI-Reise beginnen?

Jedes KI-Tool funktioniert unterschiedlich. Bestimmen Sie frühzeitig, welches Tool Sie kennenlernen möchten, und recherchieren Sie, wie es Ihre Daten verwendet, um potenzielle Bedenken zu identifizieren.

Viele Unternehmen beginnen mit dem Cyber-Security Framework (CSF) des National Institute of Standards and Technology (NIST) oder dem AI Risk Management Framework (RMF), um ihre Pläne und Richtlinien für die Implementierung aller KI oder spezifischer Technologien festzulegen. Beide Frameworks sind nützlich, um alle möglichen Risiken zu erkunden und Ihrer Organisation eine Grundlage zur Dokumentation eines Verständnisses zu geben.

Wir empfehlen Ihnen außerdem, als wesentlichen ersten Schritt eine Risikobewertung Ihrer aktuellen Sicherheitslage vorzunehmen. Wenn das Gen-KI-Tool, das Sie verwenden möchten, auf Benutzerberechtigungen angewiesen ist, stellt dies beispielsweise einen Problembereich für Ihre Datensicherheit dar.

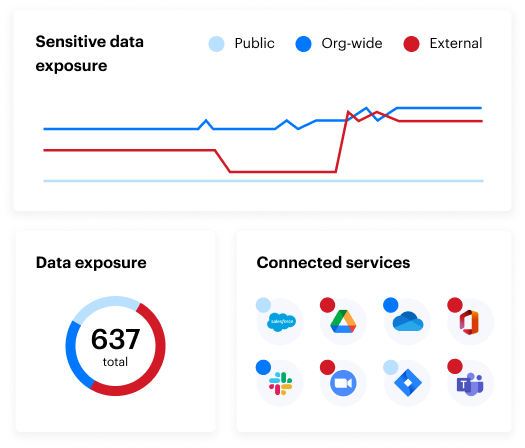

Die kostenlose Daten-Risikobewertung von Varonis lässt sich in wenigen Minuten einrichten und bietet sofortigen Mehrwert. In weniger als 24 Stunden haben Sie einen klaren, risikobasierten Überblick über die wichtigsten Daten und einen klaren Weg zur automatischen Datensicherheit.

Fragen zu KI-Sicherheitsrisiken

Während einer kürzlich abgehaltenen Kundenveranstaltung teilte ein Universitätsmitarbeiter mit, dass seine Institution an der Spitze der Entwicklung von Technologien und deren Vorteilen stehen möchte, aber unsicher ist, wie sie ihre Bedenken validieren kann.

Dies ist bei den meisten Teams der Fall. Während 67 % der Organisationen angeben, dass sie ihre Investitionen in generative KI erhöhen, fühlt sich nur ein Fünftel gut auf das damit verbundene Risikomanagement vorbereitet.

Lassen Sie uns also einige Fragen zu diesen Risiken beantworten und wie Ihre Organisation sie bekämpfen kann.

#4 Wie sollten Sie KI implementieren und dabei dieses Risiko mindern?

Bei der Einführung von KI ist es am sichersten, für Transparenz darüber zu sorgen, wer Zugang zu sensitiven Daten hat, wie diese Daten verwendet werden und wer sie benötigt, um seine Arbeit zu erledigen.

Wenn Ihr Unternehmen wenig Einblick in Ihre Datensicherheitslage hat, können Copilot für Microsoft 365 und andere generative KI-Tools vertrauliche Informationen an unbefugte Mitarbeiter oder, noch schlimmer, an Bedrohungsakteure weitergeben.

Bei Varonis haben wir eine Live-Simulation erstellt, die zeigt, welche einfachen Eingabeaufforderungen die sensitiven Daten Ihres Unternehmens in Copilot leicht preisgeben können. Während dieser Live-Demonstration teilten unsere Branchenexperten auch praktische Schritte und Strategien für eine sichere Einführung von Copilot mit und zeigten Ihnen, wie Sie die Datenexposure in Ihrem Unternehmen automatisch verhindern können.

#5 Wer übernimmt die Verantwortung, wenn KI einen Fehler macht?

Es ist wichtig, mit der Definition von „falsch“ zu beginnen. Wenn wir über eine Diskrepanz zwischen Eingabeaufforderungen und Ergebnissen sprechen, sind die Daten- und KI-Ingenieure dafür verantwortlich. Sollte „falsch“ jedoch Fehlinformationen bedeuten, die zu kritischen Entscheidungen führen, tragen die Risiko- und Governance-Ausschüsse die Verantwortung.

Vor der Implementierung einer KI-Lösung empfiehlt das NIST AI RMF, dass Organisationen eine Risikokartierung dokumentieren. Dieses Mapping würde Informationen über die Nutzerbasis und darüber, wie sie KI nutzen werden, enthalten. Die Risikokarte kann beispielsweise für ein Marktforschungsteam, das KI einsetzt, um den besten Ansatz zur Vermarktung eines Produkts zu ermitteln, ganz anders aussehen als für einen Arzt, der KI zur Erkennung einer medizinischen Diagnose einsetzt. Im letzteren Szenario könnte die Gesundheitsorganisation einen häufigeren und detaillierteren Überprüfungsprozess der Aufforderungen und Antworten einrichten wollen. Unabhängig davon sollte immer ein Mensch in den Prozess eingebunden sein und es sollten Verantwortlichkeitsebenen vorhanden sein.

Der CISO und die Rechtsteams sind letztendlich verantwortlich. Es muss jedoch ein klar definiertes Modell der geteilten Verantwortung geben.

#6 Wie hoch ist das Risiko, durch KI generierte Daten zu verwenden, die unter dem Urheberrecht oder einem Patent stehen könnten?

Menschen sollten immer eingebunden sein, um zu überprüfen, ob das, was KI mit den Nutzern teilt, den Tatsachen entspricht und urheberrechtsfrei ist. In manchen Fällen ist es vorteilhaft, zwei separate Modelle zu verwenden, um potenzielle Plagiate oder den Diebstahl von geistigem Eigentum zu validieren und zu erkennen.

#7 Wie kann ich die Risiken der Nutzung von generativer KI mindern, ohne meinem Team eine Absage zu erteilen?

Binden Sie interessierte Parteien frühzeitig und regelmäßig in den Prozess der Risiko- und Richtlinienerstellung ein. Führungskräfte sollten bei der Einführung einer neuen KI-Anwendung und der Beantwortung dieser Anfragen einen „Ja, aber“-Ansatz verfolgen.

Sie können der Anfrage grünes Licht geben und klare Zeitvorgaben setzen, während Sie den Antragsteller bitten, bei der schriftlichen Begründung zu helfen, Anwendungsfälle zu definieren und sich für Pilot- oder Betatests zur Verfügung zu stellen. Ein wohlüberlegtes und bewusstes „Ja“ führt nicht zu unkontrolliertem Chaos.

Einblicke in große Sprachmodelle (LLMs)

#8 Wie können Sie sicherstellen, dass eine Eingabe korrekt bereinigt wird, bevor sie von einem LLM beantwortet wird?

Sicherheitsverantwortliche möchten die Eingabeaufforderungen für sensitive Daten und bösartige Absichten bereinigen.

Die Echtzeitüberwachung und -bereinigung von Tastatureingaben kann in Bezug auf Rechenleistung und Latenzzeit belastend und finanziell kostspielig sein. Die Überwachung von Eingabeaufforderungen nach der Eingabe ist weitaus praktikabler, und die Sicherheitsteams stellen fest, dass die kontinuierliche Überwachung und Alarmierung effektiv dabei helfen, Insider-Risiken oder böswillige Akteure fast unmittelbar nach ihrer ersten riskanten Eingabeaufforderung zu erkennen.

Einige auf dem Markt erhältliche Data Loss Prevention (DLP)-Lösungen können einen Benutzer daran hindern, eine Datei bereitzustellen oder darauf zu verweisen, auf die ein Labeling angewendet wurde. Einige dieser Funktionen befinden sich noch in der Vorschauphase und erfordern von den Organisationen robuste Labeling-Programme. Wenn eine Datei nicht Labeling ist, wird diese Art der Bereinigung nicht verhindern, dass der Inhalt verarbeitet wird.

#9 Wie kann ich einen Jailbreak im LLM verhindern?

Ähnlich wie bei der Prompt-Bereinigung sind Echtzeitüberwachung und -erkennung entscheidend, um zu verhindern, dass ein Jailbreak-Versuch vollständig ausgeführt wird.

Einer der wichtigsten Indikatoren für einen Jailbreak-Versuch ist das Benutzerverhalten. Oft wird der Versuch von einem inaktiven Konto, einem Konto ohne typischen Zugang, einem Benutzer mit deutlich weniger Aktivität (z. B. 10 ausgeführte Aufforderungen in einem Zeitraum von fünf Minuten) usw. durchgeführt. Darüber hinaus erkennen fortschrittliche Lösungen jetzt böswillige Absichten und analysieren ungewöhnliches Verhalten (z. B. Eingabeaufforderungen zu einem Thema, das für diesen Benutzer untypisch ist).

Und schließlich kann die Klassifizierung und Erkennung von Eingabeaufforderungen Alerts auslösen, wenn ein Benutzer nach bestimmten Schlüsselwörtern oder Inhaltstypen fragt, um den Jailbreak-Versuch auf halbem Wege zu stoppen.

#10 Lohnt es sich, Ihre eigenen LLM-Modelle zu entwickeln, wenn man die hohen Kosten für Infrastruktur und Zeit bedenkt? Oder empfehlen Sie, ein SaaS-Modell zu wählen?

Organisationen finden Wert in verschiedenen „Studio“- und „Custom Agent“-Generatoren, die das Budget nicht sprengen. Es ist gut, zunächst diese Low-Code-Optionen zu erkunden, bevor Sie ein Pro-Code-Modell erstellen.

Dieser Ansatz wird den Teams ein besseres Verständnis für die Qualität ihrer vorhandenen Daten und klarere Definitionen der gewünschten Ergebnisse geben. Sicherheitsverantwortliche profitieren auch von skalierbaren Low-Code-KI-Agentengeneratoren, da sie theoretisch universelle Schutzmaßnahmen auf jeden getesteten und eingesetzten Agenten anwenden können.

Fragen zur internen Schulung für KI

#11 Sollte ich meinen Mitarbeitern Schulungen zur Nutzung von Gen-AI-Tools anbieten?

KI-Schulungen sollten unternehmensweit ausgeweitet werden – auf den Vorstand, die Geschäftsleitung, die Rechtsabteilung usw.

Viele Anbieter, wie Microsoft und Salesforce, stellen kostenlose Ressourcen für KI-Sicherheit zur Verfügung, und jede Cyber-Security- oder IT-Konferenz bietet weltweit mehrere Schulungsmöglichkeiten für KI an. Die Bereitstellung von Schulungen ist weniger eine Anforderung, aber Organisationen sollten eine Reihe von erforderlichen Kursen und Sitzungen zusammenstellen.

Das Personal und die Partner der Organisation erhalten Schulungen zum KI-Risikomanagement, um ihre Aufgaben und Verantwortlichkeiten im Einklang mit den entsprechenden Richtlinien, Verfahren und Vereinbarungen wahrnehmen zu können.

NIST AI RMF, Govern 2.2

Eine einmalige Schulung ist nicht ausreichend. Genauso wie Phishing-Simulationen regelmäßig durchgeführt werden, müssen Organisationen regelmäßige KI-Sicherheitsbewusstseins-Checkpoints mit ihren Nutzern einrichten.

#12 Sollten Gen-AI-Tools für alle in einer Organisation verfügbar sein oder nur für einige wenige?

Sie können sicherlich den Anwendungsfall für jeden in Ihrer Organisation machen, um Zugriff auf KI-Tools zu haben. Dennoch sind die meisten Organisationen nicht in der Lage, einen unternehmensweiten Einsatz wirklich in Betracht zu ziehen, weil es an Governance-Programmen mangelt.

Laut einer aktuellen Gartner-Studie haben 57 % der Organisationen ihren Copilot für Microsoft 365-Rollout im Jahr 2024 aufgrund von Benutzern mit geringem Risiko oder vertrauenswürdigen Benutzern eingeschränkt, und 40 % verzögerten ihren Rollout um drei Monate oder mehr. Daher fragen sich Unternehmen oft, ob sie KI-Tools zur Verfügung stellen können oder ob sie sollten.

Wenn Sie bei der Einführung von KI hinter Ihren Konkurrenten zurückbleiben und folglich Effizienzsteigerungen oder Innovationen verpassen, kann dies auch zu potenziellen Geschäftsrisiken führen. Organisationen erhöhen das Risiko, dass Benutzer Schatten-KI übernehmen, ohne dass ihnen genehmigte und gut verwaltete Optionen zur Verfügung gestellt werden.

#13 Sollten Sie genehmigte und/oder nicht verwaltete KI-Lösungen zulassen? Welche Richtlinien sollten Sie Ihren Mitarbeitern geben?

Das NIST AI Risk Management Framework (RMF) umfasst vier Funktionen: Steuern, Zuordnen, Messen und Verwalten. Elemente aller vier sollten auf sanktionierte KI-Lösungen und solche, die von Stakeholdern zur Genehmigung und Implementierung beantragt werden, angewendet werden.

Benutzer sollten ohne die ausdrückliche Zustimmung der Sicherheits- und IT-Teams keine KI-Anwendungen herunterladen, verwenden oder erstellen können. Umgekehrt sollten sie über effiziente und einfache Verfahren verfügen, um angemessenen Zugang oder Privilegien für KI zu beantragen.

Als Ausgangspunkt können die Benutzer in einem einfachen Fragebogen grundlegende Informationen über die positiven und vorteilhaften Anwendungen des vorgeschlagenen KI-Systems, die Gesamtanzahl der Benutzer, die von der KI zu verwendenden Daten sowie die bekannten Kosten und Risiken bereitstellen. Benutzer und Geschäftsinteressenten müssen gemeinsam Verantwortung übernehmen und über die Nutzung von KI informiert sein. Wenn Sie nicht in der Lage sind, die potenziellen Vorteile und die damit verbundenen Risiken ansatzweise zu erläutern, dann wird die Implementierung wahrscheinlich scheitern. Misserfolg kann in Form von verschwendeten Einnahmen und Unternehmensressourcen oder KI-Missbrauch auftreten.

Organisationen müssen ihre nicht verhandelbaren Punkte für KI verstehen, um festzulegen, welche Richtlinien für die Mitarbeiter eingeführt werden müssen. Zum Beispiel können Sie festlegen, dass bestimmte regulierte Daten niemals in oder von KI verwendet werden dürfen (z. B. ITAR-Daten oder bestimmte PII). Diese Bedingungen können sich ändern, wenn die Organisation ihre Governance- und Managementfähigkeiten weiterentwickelt oder sich die geschäftlichen Umstände ändern. Anfänglich kann es den Benutzern untersagt sein, über ihr verwaltetes mobiles Gerät oder eine Web-App auf KI-Anwendungen zuzugreifen; nach einiger Zeit und weiteren Analysen kann dies jedoch zu einer akzeptablen Nutzung werden.

Fragen zur Datensicherheit von KI

#14 Wie wichtig sind Datenklassifizierung und DLP beim Einsatz von KI? Sollte das zu den ersten Schritten gehören?

Zu wissen, auf welche Daten oder Ressourcen die KI zugreift, ist grundlegend.

Wenn die Daten falsch oder nicht klassifiziert sind, fehlt der Organisation eine zuverlässige Kontrolle über bestimmte Datentypen. Nicht-HR-Benutzer sollten nicht in der Lage sein, HR-gesteuerte Daten anzufordern, aber es ist unmöglich, die KI-Zugriffskontrolle durchzusetzen, wenn diese Daten nicht klassifiziert und verwaltet werden.

Organisationen müssen die Klassifizierung in einem breiteren und langfristigen Sinne betrachten. Viele Organisationen werden schließlich mehr als eine Unternehmens-KI-Lösung in ihrer Umgebung einsetzen, und dieses Multi-KI-Modell wird auf mehrere Datenquellen zugreifen. Daher sollten die jetzt zur Klassifizierung von Daten implementierten Richtlinien und Technologien erweiterbar und kontinuierlich über mehrere Cloud-Ressourcen hinweg sein. Eine einzige Lösung für die Klassifizierung von Daten in Salesforce und Azure zu haben, wird für die Zukunft der Multi-AI-Einführung nicht geeignet sein.

DLP ist ein Schlüsselelement für die Überwachung und Verwaltung von KI gemäß dem NIST AI RMF; jedoch ist DLP eine nachgelagerte Kontrolle, die nicht der erste Schritt sein kann. Nichtsdestotrotz kann es ein erstes Element sein, das in den frühen Planungs- und Strategiephasen berücksichtigt werden sollte.

#15 Können Sie bei der Einführung von Copilot die Bedeutung des Least-Privilege-Prinzips in einer Organisation hervorheben?

Das Least-Privilege-Prinzip steht an erster Stelle. In der Praxis ist das automatisierte Least-Privilege-Prinzip am effektivsten. Daten werden in einem schwindelerregenden Tempo erstellt und verändert, sodass die Sicherheits- und Risikoteams nicht in der Lage sind, die Richtlinien des Least-Privilege-Prinzips manuell zu konfigurieren, um Schritt zu halten. Menschen und Identitäten entwickeln sich ebenfalls in ähnlichem Tempo.

Durch Automatisierung können Organisationen ihre Richtlinien und den Zugriff realistischer anpassen, basierend auf Änderungen bei Daten und Identitäten. Eine Ressource enthielt in der Vergangenheit möglicherweise keine sensitiven Daten, aber durch eine einzige Aktion könnte sie mit Informationen gefüllt werden, die eine strengere Kontrolle erfordern. Ein weiteres Beispiel für diese Dynamik ist, wenn ein Benutzer oder Administrator versehentlich oder böswillig die Berechtigungen für eine Ressource ändert und eine ‚Abweichung‘ von den ursprünglichen Konfigurationen verursacht. Automatisierte Erkennung und Sanierung können solche Änderungen adaptiv erkennen und ohne größere Eingriffe beheben.

Fragen zu Copilot für Microsoft 365

#16 Was sind die ersten Schritte, bevor Sie Copilot in Ihrer Organisation bereitstellen?

Bevor Sie Microsoft 365 Copilot in Ihrer Organisation einsetzen , ist es hilfreich, eine KI-Governance-Gruppe oder ein Gremium einzurichten. Diese Gruppe sollte Vertreter aus den Bereichen Compliance, Identität, Sicherheitsteams und Führungskräfte aus der Wirtschaft umfassen.

Die Governance-Gruppe wird dafür verantwortlich sein, klare Governance- und Nutzungsrichtlinien für Copilot zu erstellen, um sicherzustellen, dass alle Beteiligten abgestimmt sind und der Einsatz gut koordiniert ist. Darüber hinaus können Organisationen die ideale Datensicherheitsplattform evaluieren, um sich vor Laufzeit- und ruhenden Datenrisiken zu schützen.

Ein weiterer wesentlicher Schritt in diese Richtung ist die Verbesserung der zugrundeliegenden Governance innerhalb des Microsoft 365-Tenants. Organisationen sollten sich darauf konzentrieren, die Risiken des Oversharings zu mindern, indem sie mit Sicherheits- und Compliance-Teams zusammenarbeiten, um skalierbare und automatisierte Tools zur Klassifizierung, zum Schutz und zur Verwaltung von Inhalten während ihres gesamten Lebenszyklus zu implementieren.

Schließlich ist die Entwicklung von bewährten Verfahren und Schulungen nützlich, um Mitarbeitern zu helfen, Informationen sicher zu speichern und auszutauschen. Die Integration dieser Schulung in das Onboarding der Mitarbeiter und die obligatorischen Sicherheitsschulungen wird eine breitere Akzeptanz fördern und sicherstellen, dass die Mitarbeiter gut darauf vorbereitet sind, Copilot oder andere KI-Lösungen verantwortungsvoll zu nutzen.

Datensicherheitsstrategien für eine Gen-AI-Welt

#17 Ist Copilot die Investition wert?

Wie jede andere KI-Lösung ist auch Copilot nur so wertvoll wie die Daten, auf die zugegriffen wird. Das Beschränken ganzer Websites und das Abhacken des Datenzugriffs mit einer großen, unhandlichen Axt kann den Wert von Copilot einschränken. Ein intelligentes Datenzugriffsprogramm kann Berechtigungen gezielter steuern, ohne den Wert zu mindern.

In Copilot zu investieren kann Organisationen, die ihre Produktivität steigern und Abläufe optimieren möchten, erheblich zugutekommen. Das Tool ist so konzipiert, dass es sich nahtlos in bestehende Microsoft 365-Anwendungen integrieren lässt und den Anwendern eine KI-gesteuerte Unterstützung bietet, die Routineaufgaben automatisieren und die Effizienz verbessern kann. Um eine effektive und sichere Bereitstellung zu gewährleisten, müssen jedoch unbedingt Sicherheits- und Governance-Bedenken berücksichtigt werden.

Darüber hinaus werden Organisationen mit starken Informations-Governance-Praktiken wahrscheinlich eine bessere Akzeptanz und einen besseren Nutzen von Copilot erleben. Indem sie sich darauf konzentrieren, Risiken wie das Teilen von zu vielen Informationen und Fehlinformationen zu minimieren, können Unternehmen den Wert ihrer Investition maximieren. Um die Sicherheit und Effektivität von Copilot langfristig aufrechtzuerhalten, sind kontinuierliches Monitoring und adaptive Governance von entscheidender Bedeutung.

Fragen zur Einhaltung von KI-Vorschriften

#18 Gibt es regulatorische Anforderungen, die ein Unternehmen vor der Einführung von KI erfüllen muss?

Regulatorische Anforderungen folgen in vielen Fällen den Daten. Alle Datensätze oder Informationssysteme, die in den Anwendungsbereich einer derzeit geltenden Verordnung fallen, werden dazu führen, dass diese Anforderungen von den KI-Systemen, die auf diese Daten zugreifen, übernommen werden.

Zum Beispiel müssen Organisationen im Rahmen des Cyber-Security Maturity Model Certification (CMMC) -Programms durch eine Bewertung nachweisen, dass sie Federal Contract Information (FCI) und Controlled Unclassified Information (CUI) schützen. Eine Organisation mit CMMC-Anforderungen muss die Multifaktor-Authentifizierung (MFA) auf alle Systeme anwenden, die CUI enthalten, damit Benutzer auf diese zugreifen können. Dann müssten sie außerdem MFA für Benutzer verlangen, die auf KI-Anwendungen zugreifen, die dieselben Daten verarbeiten.

Selbst wenn die Organisation über schriftliche Dokumentationen und Richtlinien verfügt, die die Nutzung von CUI durch eine LLM- oder KI-Anwendung untersagen, muss sie die Anforderungen erfüllen, um Basiskonfigurationen zu etablieren und aufrechtzuerhalten, die verhindern, dass Benutzer dies tun. Außerdem müsste es die protokollierte Ereignisse, wie die Eingabeaufforderungen des KI-Agenten und die Ergebnisse überprüfen, um festzustellen, ob auf CUI zugegriffen wurde.

Derzeit gibt es keine Vorschriften, die explizit auf KI abzielen und vollständig durch Gesetz, Durchsetzung und Strafen etabliert sind. Das EU-KI-Gesetz hat beispielsweise derzeit einige Kapitel in Kraft, andere jedoch nicht. Außerdem gibt es derzeit keine Durchsetzungsbehörde.

Es ist auch wichtig zu erkennen, dass viele der sich entwickelnden Vorschriften, die auf KI abzielen, hauptsächlich Angebote von KI und LLM betreffen, die für die Nutzung durch externe Parteien erstellt wurden (z. B. eine Direct-to-Consumer-Anwendung wie ChatGPT und wie OpenAI diese entwickelt und verwaltet). Frühere US Executive Orders und andere beinhalten Vorschriften, die auf Voreingenommenheit und Entscheidungsfindung ausgerichtet sind.

#19 Wird der Wert einer KI-Management-Zertifizierung wie ISO 42001 steigen?

In den meisten Fällen wird der Wert, der mit einem Zertifikat oder einer Akkreditierung verbunden ist, das Verhalten von Verbrauchern oder Kunden in Unternehmen nicht verändern. Es wird wenig geschäftlichen Nutzen in Bezug auf die Marke, die Marktfähigkeit oder den Umsatz geben. In der Praxis ist die Teilnahme an einer ISO 42001-Schulung und am Zertifizierungsprozess jedoch von unschätzbarem Wert, da das Nebenprodukt dieser Übung die Dokumentation ist.

Es ist sehr herausfordernd für Organisationen, durchdachte Richtlinien zu erstellen, die richtigen Rollen und Verantwortlichkeiten zu definieren und zuzuweisen und technische Risikomanagementlösungen von Grund auf zu implementieren. Daher bietet ein Rahmenwerk wie ISO 42001 eine geeignete Struktur für nahezu jede Organisation, unabhängig von ihrer Größe oder Branche, um ihr KI-Managementprogramm zu definieren. Viele Vorschriften erhöhen ihre Anforderungen an die Dokumentation, wie etwa HIPAA, und die durch die Vorbereitung auf ISO 42001 erstellten Artefakte werden der Organisation wiederum helfen, andere regulatorische Anforderungen zu erfüllen.

Der Zertifizierungsprozess deckt auch Risiken auf, die durch die Analyse, Entdeckung und die verschiedenen Perspektiven, die während der Zertifizierung erforderlich sind, entstehen. Bei der Durchführung einer Varonis Data Risk Assessment (DRA) entdecken Kunden oft zuvor unbekannte Risiken. Jedes Mal, wenn eine Organisation ihre eigenen Sicherheitsvorkehrungen und -praktiken analysieren kann, ist dies eine Gelegenheit, ihren Systemsicherheitsplan zu verbessern und anzupassen.

Fragen zu KI-gestützten Tools und zur Automatisierung

#20 Was sind die richtigen Fragen bei der Bewertung eines Anbieters, der KI einsetzt?

Die richtigen Fragen können von den Datenschutz- und/oder regulatorischen Anforderungen Ihres Unternehmens abhängen. Im Allgemeinen sollten Sie Fragen zu den folgenden Bereichen stellen:

- Welche Daten wird der Anbieter verarbeiten, wo werden diese Daten verarbeitet (Datenresidenz) und wie werden sie verarbeitet?

- Werden die von der Lösung für maschinelles Lernen oder KI verwendeten Daten anderen Stellen oder Benutzern außerhalb meines Unternehmens zur Verfügung stehen? Wird es zum Trainieren eines Modells verwendet werden? Wenn ja, wie?

- Mit welchen Gesetzen und Vorschriften halten Sie sich derzeit ein oder richten sich danach, und haben Sie dazugehörige Dokumentationen oder dokumentierte Vereinbarungen?

- Welche Sicherheitsarchitektur ist in die Nutzung und Entwicklung von KI eingebettet? Hat das Unternehmen Maßnahmen zur Minderung und die Fähigkeit, Schwachstellen und/oder Bedrohungen für das/die KI-System(e) zu erkennen?

#21 Können Sie KI für die Sicherheitsautomatisierung verwenden? Welche Auswirkungen gibt es?

Bei Varonis nutzen unsere Managed Data Detection and Response (MDDR)-Kunden unsere KI-gestützte Datensicherheitsplattform, um führende Datenbedrohungen mit hoher Geschwindigkeit und Effizienz zu erkennen und darauf zu reagieren. Darüber hinaus kann unser MDDR-Angebot mit verschiedenen EDR- und XDR-Lösungen integriert werden, um eine einfache KI-Abfrage gegen mehrere Sätze von Bedrohungs-Telemetriedaten zu ermöglichen.

Es gibt erste Anzeichen dafür, dass Analysten und Praktiker umfangreiche Quellen von Unternehmensdaten und externer Bedrohungsaufklärung effektiv abfragen können, um Bedrohungen schneller zu identifizieren und darauf zu reagieren. Außerdem werden für Analysten sich wiederholende Aufgaben und Alerts eliminiert.

#22 Was ist Ihre Meinung zu KI-gestützten Tools, die in der Schatten-IT verwendet werden?

In der Unternehmens-IT-Landschaft entwickeln sich zwei riskante Szenarien. Die erste ist Schatten-KI, über die ich kürzlich auf LinkedIn gesprochen habe, und die zweite sind Schatten-IT-Anwendungen, die KI nutzen und dabei Unternehmensdaten verwenden.

Gartner prognostizierte im Jahr 2016, dass bis 2020 ein Drittel der erfolgreichen Angriffe, die Unternehmen erleben, auf ihre Schatten-IT-Ressourcen abzielen werden. Diese Vorhersage gilt auch noch im Jahr 2025, in dem wir sehen, dass „Schatten-KI“ zu einem führenden Angriffsvektor und Risiko für die Exposure wird. DeepSeek ist eines der jüngsten und bemerkenswertesten Beispiele. Dennoch werden die Benutzer weiterhin neue KI-Anwendungen testen und erforschen, wenn sie die Möglichkeit dazu haben oder wenn die Management-Tools sie nicht daran hindern.

Letztendlich ist es wichtig, dass Organisationen ihren Nutzern und Entwicklern sichere und geschützte Optionen zur Verfügung stellen und die Notwendigkeit, andere Optionen auszuprobieren, mindern. Ein klarer Weg zum Testen und zur Zulassung neuer KI-Lösungen muss ebenfalls klar definiert sein.

Verringern Sie Ihr Risiko, ohne neue Risiken einzugehen.

Diese Liste von KI-Sicherheitsfragen ist nicht vollständig, enthält jedoch einige der häufig gestellten Fragen, die wir bei Varonis erhalten. Wir überarbeiten und ergänzen diesen Blog regelmäßig, da sich Technologien, Vorschriften und Bedrohungen ändern.

Ihre Frage wurde nicht beantwortet? Kontaktieren Sie unser Team, damit wir das ändern können.

Sind Sie bereit, Ihre KI-Reise sicher zu starten? Fangen Sie mit dem kostenlosen Data Risk Assessment von Varonis an. In weniger als 24 Stunden haben Sie einen klaren, risikobasierten Überblick über die wichtigsten Daten und einen klaren Weg zur automatischen Sanierung.

Wie soll ich vorgehen?

Im Folgenden finden Sie drei Möglichkeiten, wie Sie das Datenrisiko in Ihrem Unternehmen verringern können:

Vereinbaren Sie eine Demo mit uns, um Varonis in Aktion zu erleben. Wir passen die Session an die Datensicherheitsanforderungen Ihres Unternehmens an und beantworten alle Fragen.

Sehen Sie sich ein Beispiel unserer Datenrisikobewertung an und erfahren Sie, welche Risiken in Ihrer Umgebung lauern könnten. Varonis DRA ist völlig kostenlos und bietet einen klaren Weg zur automatischen Sanierung.

Folgen Sie uns auf LinkedIn, YouTubeund X (Twitter), um kurze Einblicke in alle Themen der Datensicherheit zu erhalten, einschließlich Data Security Posture Management (DSPM), Bedrohungserkennung, KI-Sicherheit und mehr.

-1.png)