Les équipes de sécurité se posent de plus en plus de questions sur l'IA générative, car elle est intégrée à de nombreuses solutions SaaS et plateformes cloud à un rythme effréné.

Malgré le pouvoir qu'a l'IA d'accroître la productivité des entreprises, les dirigeants évaluent le coût des risques de sécurité qui lui sont associés. La sécurisation des données sensibles auxquelles l'IA a accès est naturellement une priorité élevée, et les entreprises tentent de permettre en toute sécurité l'utilisation des outils d'IA générative et de créer un plan de cycle de vie à long terme.

Par le biais de nombreux webinaires, d'échanges avec les clients, de tables rondes rassemblant des RSSI et d'évaluations de risques menées chez Varonis, nous aidons à répondre aux nombreuses questions récurrentes à propos de l'IA et des risques de sécurité liés à son déploiement dans les entreprises. Ce blog est une synthèse des principales questions et réponses extraites de ce dialogue.

Grâce aux réponses aux principales questions relatives à la sécurité de l'IA, vous serez en mesure de prendre des décisions organisationnelles en toute confiance et de découvrir des plans et stratégies spécifiques à étudier. Voyons ça de plus près.

Questions générales relatives à la sécurité de l'IA

‑ 1 Qu’est-ce que la sécurité de l’IA ?

Selon la définition donnée à l'IA, la sécurité de l'IA peut signifier beaucoup de choses.

La sécurité de l'IA peut concerner la protection des informations contre les outils d'IA tels que les grands modèles linguistiques (LLM). Les entreprises cherchent à gérer l'accès aux données, à se protéger contre les abus et à surveiller les menaces telles que le débridage ou l'empoisonnement des données. Un aspect de la sécurité de l'IA dans ce contexte peut inclure la prévention de l'IA fantôme.

La sécurité de l'IA comprend également l'utilisation de l'IA pour renforcer la posture de sécurité d'une entreprise. La mise en œuvre de la cybersécurité alimentée par l'IA peut aider les entreprises à combattre les cyberattaques et les fuites de données, à améliorer les efforts de remédiation et à réduire le temps de détection.

Étant donné que l’adoption de l’IA s’est accélérée, les entreprises doivent avoir une visibilité et un contrôle complets sur les outils d'IA et les charges de travail associées. Cela plaide en faveur de la sécurité de l'IA en tant que partie intégrante de la sécurité des données. Une sécurité adéquate de l'IA aide les entreprises à déployer des outils en toute sécurité et à combattre le risque de fuite d'informations sensibles.

#2 Ne devrions-nous pas attendre que l'IA mûrisse davantage avant de nous y lancer ?

Notre monde ne reviendra pas aux jours d'avant l'IA, donc si vous ne réfléchissez pas déjà à la manière de l'intégrer à votre entreprise ou à son fonctionnement, vous prendrez un retard irrattrapable.

Par ailleurs, l'autre risque important auquel les entreprises commencent à être confrontées est celui de l'IA fantôme : les utilisateurs téléchargent et utilisent des applications d'IA non approuvées en l'absence de proposition d'un outil approprié de la part du service informatique. Les téléchargements galopants de DeepSeek constituent un exemple récent de cette tendance.

Cependant, nous vous déconseillons d’exploiter les outils d’IA dans votre entreprise sans vous être correctement formé à leur utilisation au préalable. Il est important de comprendre tous les avantages et les risques, ainsi que la manière dont certaines solutions utilisent les données que vous leur confiez, afin de vous assurer que vous pouvez sécuriser correctement les informations critiques avant leur déploiement.

« À bien des égards, l'IA et l'IA générative représentent l'occasion pour la sécurité de montrer l'exemple et d'en démontrer aux autres les avantages », a déclaré Matt Radolec, vice-président de Varonis chargé de la réponse aux incidents et des activités cloud, lors d'un webinaire avec des RSSI et d'autres leaders du secteur sur le sujet. « Ces outils peuvent être utilisés en toute sécurité et il y a clairement un bénéfice à en tirer. »

‑ 3 Quelles sont les ressources disponibles pour ceux qui débutent leur parcours dans l'IA ?

Chaque outil d'IA fonctionne différemment. Déterminez dès le début quel outil vous souhaitez maîtriser et recherchez comment il utilise vos données pour identifier les problèmes potentiels.

De nombreuses entreprises commencent par le Cadre de cybersécurité (CSF) du National Institute of Standards and Technology (NIST) ou le Cadre de gestion du risque lié à l'IA (RMF) pour établir leurs plans et politiques de mise en œuvre de l'IA ou de technologies spécifiques. Les deux cadres sont utiles pour étudier tous les risques possibles et fournir à votre entreprise un plan pour documenter et comprendre la situation.

Nous vous recommandons également de procéder à une évaluation des risques liés à votre posture de sécurité actuelle comme première étape essentielle. Si l'outil d'IA générative que vous souhaitez utiliser dépend des autorisations des utilisateurs, par exemple, cela constitue un problème pour la sécurité de vos données.

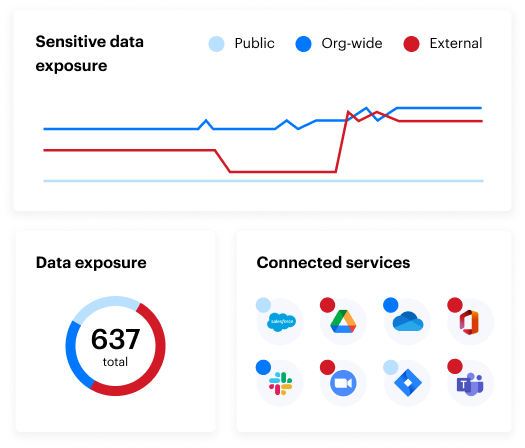

L’évaluation des risques sur vos données gratuite de Varonis ne prend que quelques minutes et vous apporte une valeur immédiate. En moins de 24 heures, vous disposerez d’une vue claire et basée sur les risques des données les plus importantes, et d’un parcours clair vers une sécurité des données automatisée.

Questions relatives aux risques de sécurité de l'IA

Lors d'un récent évènement client, un employé d'université a parlé de la volonté qu'a l'institution à laquelle il appartient d'être à la pointe du développement technologique et des avantages associés, mais aussi du fait qu'elle ne sait pas comment aborder les problèmes qui y sont liés.

C'est le cas pour la plupart des équipes. Alors que 67 % des entreprises déclarent augmenter leurs investissements dans l'IA générative, seul un cinquième d'entre elles se sentent très bien préparées à la gestion des risques qui y sont associés.

Répondons donc à quelques questions sur ces risques et sur la manière dont votre entreprise peut les combattre.

‑ 4 Comment adopter l'IA et atténuer ce risque ?

Lorsque vous adoptez l'IA, la meilleure façon de le faire en toute sécurité est d'assurer la visibilité sur qui a accès aux données sensibles, comment elles sont utilisées et qui en a besoin pour accomplir ses tâches.

Si votre entreprise n'a pas une bonne visibilité sur votre posture de sécurité des données, Copilot pour Microsoft 365 et d'autres outils d'IA générative sont susceptibles de divulguer des informations sensibles à des employés qui ne devraient pas y avoir accès, ou pire encore, à des acteurs malveillants.

Chez Varonis, nous avons créé une simulation en direct qui montre comment de simples invites peuvent facilement exposer les données sensibles de votre entreprise dans Copilot. Au cours de cette démonstration en direct, nos experts du secteur ont également partagé des bonnes pratiques et des stratégies destinées à assurer un déploiement sécurisé de Copilot et vous montrer comment empêcher automatiquement l'exposition des données au sein de votre entreprise.

‑ 5 Qui est responsable lorsque l'IA se trompe ?

Il est important de commencer par la définition de l'erreur. S'il s'agit d’un décalage entre les invites et les résultats, alors les spécialistes en données et les spécialistes en IA en sont responsables. Cependant, si « erreur » équivaut à des informations erronées qui mènent à une prise de décision critique, les comités de gestion des risques et de gouvernance en sont responsables.

Avant de mettre en œuvre une solution d’IA, le Cadre de gestion du risque lié à l'IA recommande que les entreprises documentent la cartographie des risques. Cette cartographie doit comprendre les informations relatives à la base d’utilisateurs et sur la manière dont ceux-ci utiliseront l’IA. La cartographie des risques, par exemple, peut être radicalement différente s'il s'agit d'une équipe d'études de marché utilisant l'IA pour déterminer la meilleure approche pour commercialiser un produit, ou d'un médecin utilisant l'IA pour établir un diagnostic médical. Dans ce dernier cas, l'organisme de santé peut souhaiter mettre en place un processus d'examen plus fréquent et plus détaillé des invites et des réponses. Quoi qu’il en soit, il doit toujours y avoir une place laissée à l'humain dans le processus et des niveaux de responsabilité clairement établis.

Le RSSI et les équipes juridiques sont responsables en dernier ressort, cependant, il doit y avoir un modèle de responsabilité partagée clairement défini.

‑ 6 Quel est le risque d'utiliser des données générées par l'IA qui pourraient être protégées par un droit d'auteur ou un brevet ?

Les humains doivent toujours faire partie du processus, afin de vérifier que ce que l'IA partage avec les utilisateurs est factuel et exempt de droits d'auteur. Dans certains cas, il est avantageux d'utiliser deux modèles distincts pour valider et détecter un éventuel plagiat ou vol de propriété intellectuelle.

‑ 7 Comment puis-je atténuer les risques liés à l'utilisation de l'IA générative sans dire non à mon équipe ?

Impliquez les parties prenantes dès le début et fréquemment dans le processus de génération des risques et des politiques. Les dirigeants doivent adopter une approche du type « oui, mais » lorsqu'ils introduisent une nouvelle application d'IA et traitent ces demandes.

Vous pouvez donner le feu vert à la demande et définir des attentes claires en matière de délais, tout en chargeant le demandeur de contribuer à la rédaction de la justification écrite, de définir les cas d'utilisation et de se porter volontaire pour tester le projet pilote ou la version bêta. Un « oui » réfléchi et conscient n'est pas synonyme de chaos absolu.

À propos des grands modèles linguistiques (LLM)

‑ 8 Comment puis-je m’assurer qu’une invite est correctement nettoyée avant d’être traitée par un LLM ?

Les responsables de la sécurité veulent nettoyer les invites pour éviter les fuites de données sensibles et la mise en œuvre d'intentions malveillantes.

La surveillance et le nettoyage des frappes en temps réel peuvent être exigeantes en termes de puissance de calcul et de latence, et sont coûteuses financièrement. La surveillance des invites après l'entrée est beaucoup plus faisable, et les équipes de sécurité constatent que la surveillance et les alertes continues sont efficaces pour détecter les risques internes ou les acteurs malveillants presque immédiatement dès leur première invite à risque.

Certaines solutions de prévention des pertes de données (DLP) disponibles sur le marché peuvent empêcher un utilisateur de fournir ou de référencer un fichier sur lequel une étiquettes de confidentialité a été apposée. Certaines de ces fonctionnalités ne sont disponibles qu'en version d'essai et nécessitent que les entreprises disposent de programmes d'étiquetage robustes. Si un fichier n'est pas étiqueté, ce type de nettoyage n'empêchera pas le traitement du contenu.

‑ 9 Comment puis-je empêcher un débridage du LLM ?

Tout comme pour le nettoyage des invites, la surveillance et la détection en temps réel sont essentielles pour empêcher qu'une tentative de débridage ne s'exécute complètement.

L’un des indicateurs clés d’une tentative de débridage est le comportement de l’utilisateur. Souvent, la tentative est menée par un compte obsolète, un compte sans accès habituel, un utilisateur beaucoup moins actif (par exemple, 10 invites exécutées en cinq minutes), etc. De plus, des solutions avancées détectent désormais les intentions malveillantes et les comportements étranges (par exemple, des invites relatives à un sujet qui n'est généralement pas abordé par cet utilisateur).

Enfin, la classification et la détection des invites peuvent déclencher des alertes lorsqu'un utilisateur demande certains mots-clés ou types de contenu pour arrêter la tentative de débridage en cours.

‑10 Est-ce rentable de créer ses propres modèles LLM, compte tenu des ressources nécessaires, en termes d’infrastructure et de temps à y consacrer ? Recommandez-vous plutôt d'opter pour un modèle SaaS ?

Les entreprises trouvent intéressants les divers générateurs de type « studio » et « agent personnalisé » qui ne coûtent pas cher. Il est bon d'examiner d'abord ces options de type « low-code » avant de créer un modèle de type « pro-code ».

Cette approche donnera aux équipes une meilleure compréhension de la qualité de leurs données actuelles et des définitions plus claires des résultats souhaités. Les responsables de la sécurité bénéficient également de générateurs d’agents d’IA de type « low-code » évolutifs, car ils peuvent théoriquement appliquer universellement des protections à tout agent testé et déployé.

Questions relatives à la formation interne à l’IA

‑ 11 Dois-je proposer une formation relative à l'utilisation des outils d'IA générative à mes employés ?

La formation à l'IA devrait être étendue à l'ensemble de l'entreprise : au conseil d'administration, à l'équipe dirigeante, aux équipes juridiques, etc.

De nombreux fournisseurs, tels que Microsoft et Salesforce, proposent des ressources gratuites en matière de sécurité de l'IA, et chaque conférence relative à la cybersécurité ou à l'informatique offre de nombreuses possibilités de formation à l'IA à travers le monde. Fournir des formations n'est pas une exigence absolue, mais les entreprises devraient organiser un ensemble de cours et de séances obligatoires.

Le personnel et les partenaires de l'entreprise reçoivent une formation à la gestion des risques liés à l'IA pour leur permettre de s'acquitter de leurs tâches et responsabilités conformément aux politiques, procédures et accords pertinents.

Cadre de gestion du risque lié à l'IA du NIST, Govern 2.2

Une formation unique ne suffit pas. Tout comme elles conduisent régulièrement des exercices de simulation de phishing, les entreprises doivent établir des points de contrôle réguliers pour sensibiliser leurs utilisateurs à la sécurité en matière d'IA.

‑ 12 Les outils d'IA générative devraient-ils être accessibles à tous dans l'entreprise, ou limités à quelques-uns ?

Il est tout à fait possible d'argumenter en faveur de l'accès de l'ensemble de votre personnel aux outils d'IA. Pourtant, la plupart des entreprises sont incapables d'envisager des déploiements de cette envergure, en raison de l'absence de programmes de gouvernance.

Selon une récente étude menée par Gartner, 57 % des entreprises ont limité leur déploiement de Copilot pour Microsoft 365 en 2024 en raison de la présence d'utilisateurs à faible risque ou de confiance, et 40 % ont retardé leur déploiement de trois mois ou plus. Ainsi, les entreprises se demandent souvent si elles peuvent ou non mettre des outils d'IA à disposition de leur personnel, plutôt que de se demander si elles le devraient.

Être à la traîne par rapport aux concurrents dans l'adoption de l'IA et, par conséquent, manquer des gains d'efficacité ou des innovations peut également créer des risques potentiels pour l'entreprise. Les entreprises augmentent le risque que les utilisateurs adoptent une IA fantôme sans qu'aucune option approuvée et bien gérée ne leur soit proposée.

‑ 13 Devez-vous autoriser des solutions d'IA approuvées et/ou non gérées ? Quelles directives devez-vous donner à vos collaborateurs ?

Le Cadre de gestion du risque lié à l'IA du NIST comporte quatre fonctions : gouverner, cartographier, mesurer et gérer. Les éléments de ces quatre fonctions doivent être appliqués aux solutions d'IA autorisées et à celles demandées par les parties prenantes pour être approuvées et mises en œuvre.

Les utilisateurs ne doivent pas pouvoir télécharger, utiliser ou créer des applications d'IA sans que les équipes de sécurité et informatiques soient au courant et approuvent la démarche. À l’inverse, ils doivent disposer de processus efficaces et simples pour demander un accès à l’IA ou des privilèges raisonnables en la matière.

Pour commencer, les utilisateurs peuvent fournir des informations de base dans un simple questionnaire sur les utilisations positives et avantageuses du système d'IA proposé, le nombre total d'utilisateurs, les données destinées à être utilisées par l'IA, ainsi que les coûts et risques connus. Les utilisateurs et les parties prenantes de l'entreprise doivent avoir une responsabilité partagée et des connaissances communes sur l'utilisation de l'IA. S'ils ne peuvent pas fournir une explication rudimentaire des avantages potentiels et des risques associés, alors la mise en œuvre est susceptible d'échouer. L'échec peut se manifester sous la forme d'une perte de chiffre d'affaires et de ressources de l'entreprise, ou d'une utilisation abusive de l'IA.

Les entreprises doivent comprendre leurs impératifs en matière d’IA pour déterminer quelles directives doivent être mises en place pour les employés. Par exemple, vous pouvez déterminer que certaines données réglementées ne doivent jamais être utilisées dans ou par l'IA (par exemple les données ITAR ou certaines données à caractère personnel). Ces conditions peuvent évoluer à mesure que l'entreprise développe ses capacités de gouvernance et de gestion ou que la situation commerciale évoluent. Dans un premier temps, il peut être interdit aux utilisateurs d'accéder aux applications d'IA sur leur appareil mobile géré ou à partir d'une application web, cependant, après un certain temps et une analyse plus approfondie, cette utilisation pourrait devenir acceptable.

Questions relatives à la sécurité des données d'IA

‑ 14 Quelle est l’importance de la classification des données et de la perte de données lors de l’utilisation de l’IA ? Cela doit-il être inclus dans les étapes initiales ?

Il est fondamental de savoir à quelles données ou ressources accède l'IA.

L'entreprise manquera d'une gouvernance fiable sur certains types de données si les données sont mal classifiées ou non classifiées. Les utilisateurs non RH ne devraient pas être en mesure de lancer des invites sur les données contrôlées par les RH, par exemple, mais il est impossible d’appliquer le contrôle d’accès à l'IA si ces données ne sont pas classifiées et gérées d’une manière ou d’une autre.

Les entreprises doivent envisager la classification dans un sens plus large et à long terme. De nombreuses entreprises finiront par avoir plus d'une solution d'IA d'entreprise déployée dans leur environnement, et ce modèle multi-IA puisera dans plusieurs sources de données. Par conséquent, les politiques et technologies mises en œuvre actuellement pour classifier les données doivent être adaptables et adaptées à plusieurs ressources cloud. Disposer d'une solution pour classifier les données dans Salesforce et une autre dans Azure ne sera pas adapté à l'avenir de l'adoption de plusieurs IA.

La protection contre les pertes de données constitue un élément clé de la surveillance et de la gestion de l'IA selon le Cadre de gestion du risque lié à l'IA du NIST. Cependant, la protection contre les pertes de données est un contrôle en aval qui ne peut pas être une étape initiale. Elle peut néanmoins constituer un élément initial à prendre en compte lors des premières étapes de la planification et de la stratégie.

‑ 15 Pouvez-vous souligner l’importance du principe du moindre privilège au sein des entreprises lors du déploiement de Copilot ?

Le principe du moindre privilège est primordial. Dans la pratique, l'automatisation du principe de moindre privilège est la stratégie la plus efficace. Les données sont créées et modifiées à un rythme effréné, de sorte que les équipes de sécurité et de gestion des risques ne peuvent pas configurer manuellement les politiques de moindre privilège pour suivre. Les personnes et les identités évoluent également à un rythme similaire.

Grâce à l'automatisation, les entreprises peuvent adapter de manière plus réaliste leurs politiques et leurs accès en fonction des changements dans les données et les identités. Une ressource peut à l'origine ne pas contenir de données sensibles, mais par une seule action, elle pourrait être remplie d'informations nécessitant un contrôle accru. Un autre exemple de cette dynamique se produit lorsqu’un utilisateur ou un administrateur modifie accidentellement ou de manière malveillante les privilèges d’une ressource et provoque une « dérive » par rapport aux configurations initiales. La détection et la remédiation automatisées peuvent détecter de manière adaptative des changements de ce type et y remédier sans intervention significative.

Questions sur Copilot pour Microsoft 365

#16 Quelles sont les premières étapes avant de déployer Copilot dans votre organisation ?

Avant de déployer Microsoft 365 Copilot au sein de votre entreprise, il est utile de mettre en place un groupe ou un conseil de gouvernance de l'IA. Ce groupe doit comprendre des représentants des équipes chargées de la gestion de la conformité, des identités, de la sécurité, ainsi que des dirigeants d'entreprise.

Le groupe de gouvernance aura la responsabilité de créer des politiques claires de gouvernance et d'utilisation de Copilot, en s'assurant que toutes les parties prenantes sont sur la même longueur d'onde et que le déploiement est bien coordonné. En outre, les entreprises peuvent évaluer la plateforme de sécurité des données idéale pour se protéger contre les risques liés à l'exécution et aux données au repos.

Une autre étape essentielle dans ce sens est d'améliorer la gouvernance sous-jacente des informations au sein du locataire Microsoft 365. Les entreprises doivent se concentrer sur l’atténuation des risques de partage excessif en collaborant avec les équipes chargées de la sécurité et de la conformité pour mettre en œuvre des outils évolutifs et automatisés destinés à classifier, protéger et gérer le contenu tout au long de son cycle de vie.

Enfin, l'élaboration de directives et de formations relatives aux bonnes pratiques est utile pour aider les employés à conserver et à partager des informations en toute sécurité. L'intégration de cette formation à la prise de poste des employés et à la formation obligatoire à la sécurité favorisera une adoption plus large et garantira que les employés sont bien préparés à utiliser Copilot ou d'autres solutions d'IA de manière responsable.

Stratégies en matière de sécurité des données pour un monde soumis à l'IA générative

‑ 17 Est-ce qu'il est rentable d'investir dans Copilot ?

Comme toute autre solution d’IA, Copilot n'est précieux que par les données auxquelles il a accès. Restreindre l'accès à des sites entiers et couper l'accès aux données « à la hache » peut réduire la valeur de Copilot. Un programme d'accès intelligent aux données peut contrôler les autorisations de manière plus précise sans réduire sa valeur.

Investir dans Copilot peut grandement bénéficier aux entreprises cherchant à améliorer leur productivité et à rationaliser leurs activités. L'outil est conçu pour s'intégrer de manière transparente aux applications Microsoft 365 existantes, offrant aux utilisateurs une assistance pilotée par l'IA capable d'automatiser les tâches de routine et d'améliorer l'efficacité. Cependant, il est essentiel de traiter les problèmes potentiels de sécurité et de gouvernance pour assurer que le déploiement soit efficace et sécurisé.

En outre, les entreprises dotées de solides pratiques de gouvernance de l'information constateront probablement une meilleure adoption de Copilot et une meilleure utilité de celui-ci. En se concentrant sur la réduction des risques tels que le partage excessif et les informations erronées, les entreprises peuvent maximiser la valeur de leur investissement. La surveillance continue et la gouvernance adaptative sont cruciales pour garantir la sécurité et l'efficacité de Copilot à long terme.

Questions relatives à la conformité de l'IA

‑ 18 Existe-t-il des obligations réglementaires auxquelles les entreprises doivent se conformer avant de se lancer dans l'aventure de l'IA ?

Dans de nombreux cas, les obligations réglementaires suivent celles applicables aux données. Tous les ensembles de données ou systèmes d'information relevant d'une réglementation en vigueur entraîneront à leur tour l'application de ces obligations par les systèmes d'intelligence artificielle accédant à ces données.

Par exemple, dans le cadre du programme de certification du modèle de maturité en cybersécurité (CMMC) , les entreprises doivent valider par le biais d'une évaluation le fait qu'elles protègent les informations relatives aux contrats fédéraux (FCI) et les informations non classifiées contrôlées (CUI). Une entreprise sous le coup d'obligations liées au CMMC doit appliquer l'authentification multifactorielle à tous les systèmes contenant des informations non classifiées contrôlées pour que les utilisateurs puissent y accéder. Elle doit également mettre en place l'authentification multifactorielle pour les utilisateurs accédant aux applications d'IA qui traitent ces mêmes données.

Même si les entreprises disposent de documentation et de politiques écrites interdisant l'utilisation des informations non classifiées contrôlées par un grand modèle linguistique ou une IA, elles doivent se conformer aux obligations en matière d'établissement et de perpétuation de configurations de base empêchant les utilisateurs de le faire. En outre, elles doivent examiner les évènements journalisés, tels que les invites et les résultats de l'agent d'IA, pour déterminer si des informations non classifiées contrôlées ont été consultées.

Il n'existe actuellement aucune réglementation explicitement dédiée à l'IA qui soit entièrement fixée par la loi, son application et les sanctions associées. Ainsi, certains chapitres du règlement européen sur l’IA sont actuellement en vigueur, alors que d’autres non. En outre, il n’existe à l'heure actuelle aucun organisme de contrôle.

Il est également important de reconnaître que de nombreuses réglementations en cours d'élaboration en matière d'IA se concentrent principalement sur des offres d'IA et de grands modèles linguistiques créées pour être utilisées par des parties externes (par exemple, une application destinée aux consommateurs comme ChatGPT et la manière dont OpenAI la développe et la gère). Les précédents décrets américains et d'autres incorporent des réglementations orientées vers la partialité et la prise de décision.

‑ 19 L'obtention d'une certification de gestion de l'IA telle que l'ISO 42001 va-t-elle se traduire par une augmentation de la valeur ?

Dans la plupart des cas, la valeur associée à un certificat ou à une accréditation ne changera pas le comportement des consommateurs ou des clients envers les entreprises. Il y aura peu de valeur commerciale en termes de marque, de valeur marchande ou de chiffre d'affaires. Cependant, dans la pratique, il y a une immense valeur à suivre une formation ISO 42001 et le processus de certification, car le résultat de cet exercice est la documentation.

Il est très difficile pour les entreprises de créer des politiques soigneusement rédigées, de définir et d'attribuer les rôles et responsabilités appropriés, et de déployer des solutions de gestion des risques techniques à partir de zéro. Par conséquent, un cadre tel que l'ISO 42001 fournit un schéma adapté à presque toutes les entreprises, quelle que soit leur taille ou leur secteur, pour définir leur programme de gestion de l'IA. De nombreuses réglementations augmentent leurs exigences en matière de documentation, telles que l'HIPAA, et les artefacts créés par la préparation à l'ISO 42001 aideront l'entreprise à satisfaire d'autres obligations réglementaires.

Le processus de certification révèle également des risques en raison de l'analyse, de la découverte et des multiples perspectives requises lors de la certification. Lorsqu'ils effectuent une évaluation des risques sur les données (DRA), les clients découvrent souvent des risques inconnus auparavant. Chaque fois qu'une entreprise peut analyser ses propres mesures de protection et ses pratiques, c'est une occasion de se développer et de modifier son plan de sécurité du système.

Questions relatives aux outils alimentés par l'IA et à l'automatisation

‑ 20 Quelles sont les bonnes questions à poser lors de l'évaluation d'un fournisseur utilisant l'IA ?

Les bonnes questions peuvent dépendre des exigences de votre entité en matière de protection de la vie privée et/ou des obligations réglementaires. En général, vous devriez poser des questions sur les domaines suivants :

- Quelles données le fournisseur traitera-t-il, où ces données seront-elles traitées (résidence) et comment seront-elles traitées ?

- Les données utilisées par la solution d'apprentissage automatique ou d'intelligence artificielle seront-elles accessibles à d'autres entités ou utilisateurs que mon entreprise ? Sera-t-elle utilisée pour former un modèle ? Si c'est le cas, comment ?

- Quelles lois et réglementations respectez-vous actuellement ou avec lesquelles vous vous alignez, et avez-vous des documents ou des accords documentés à cet effet ?

- Quelle architecture de sécurité est intégrée dans l'utilisation et le développement de l'IA ? L'entreprise a-t-elle mis des mesures d'atténuation en place et dispose-t-elle de la capacité de détecter les vulnérabilités et/ou les menaces du/envers le(s) système(s) d'IA ?

‑ 21 L’IA peut-elle être utilisée pour l’automatisation de la sécurité ? Quels en sont les impacts ?

Chez Varonis, nos clients ayant adopté la solution Managed Data Detection and Response (MDDR) utilisent notre plateforme de sécurité des données alimentée par l'IA pour détecter et répondre aux principales menaces pesant sur les données avec une rapidité et une efficacité remarquables. En outre, notre offre MDDR peut s'intégrer à diverses solutions EDR et XDR pour permettre des requêtes IA faciles sur plusieurs ensembles de télémétrie des menaces.

Il existe des signes précurseurs indiquant que les analystes et les praticiens peuvent interroger efficacement de vastes sources de données d'une entreprise et de renseignements sur les menaces externes pour identifier plus rapidement les menaces et y répondre. En outre, les tâches répétitives et les fausses alarmes ne viennent plus distraire les analystes.

‑ 22 Quelle est votre opinion concernant les outils alimentés par l'IA utilisés dans l'informatique fantôme ?

Deux scénarios à risque coexistent dans le paysage informatique des entreprises. Le premier est l'IA fantôme, dont j'ai récemment discuté sur LinkedIn, et le second concerne les applications informatiques fantômes qui utilisent l'IA et les données de l'entreprise dans le processus.

En 2016, Gartner a prédit qu'en 2020, un tiers des attaques réussies subies par les entreprises cibleront leurs propres ressources informatiques fantômes. Cette prédiction reste valable en 2025, et nous voyons désormais l'IA fantôme devenir un vecteur d'attaque majeur et constituer un risque d'exposition des données. DeepSeek en est l'un des exemples les plus récents et remarquables. Néanmoins, les utilisateurs continueront à tester et à examiner de nouvelles applications d'IA s'ils en ont l'occasion ou si les outils de gestion ne les en empêchent pas.

En fin de compte, il est important que les entreprises proposent des options sûres et sécurisées à leurs utilisateurs et à leurs développeurs afin qu'ils n'aient pas besoin de se tourner vers d'autres options. Il est également nécessaire de disposer d'un processus clair pour tester de nouvelles solutions d'IA et obtenir leur validation.

Réduisez vos risques sans en prendre aucun.

Cette liste de questions relatives à la sécurité de l'IA n'est pas exhaustive, mais elle comprend certaines des questions les plus récurrentes que nous recevons chez Varonis. Nous révisons régulièrement ce blog et y ajoutons les informations pertinentes à mesure que la technologie, les réglementations et les menaces évoluent.

Vous ne trouvez pas de réponse à votre question ? Contactez notre équipe afin que nous puissions changer cela.

Êtes-vous prêt à vous lancer en toute sécurité dans l'aventure de l'IA ? Commencez par l’évaluation gratuite des risques sur vos données menée par Varonis. En moins de 24 heures, vous disposerez d’une vue claire et basée sur les risques liés aux données les plus importantes et d’un parcours clair vers la remédiation automatisée.

Que dois-je faire maintenant ?

Vous trouverez ci-dessous trois solutions pour poursuivre vos efforts visant à réduire les risques liés aux données dans votre entreprise:

Planifiez une démonstration avec nous pour voir Varonis en action. Nous personnaliserons la session en fonction des besoins de votre organisation en matière de sécurité des données et répondrons à vos questions.

Consultez un exemple de notre évaluation des risques liés aux données et découvrez les risques qui pourraient subsister dans votre environnement. Cette évaluation est gratuite et vous montre clairement comment procéder à une remédiation automatisée.

Suivez-nous sur LinkedIn, YouTube et X (Twitter) for pour obtenir des informations sur tous les aspects de la sécurité des données, y compris la DSPM, la détection des menaces, la sécurité de l’IA et plus encore.

-1.png)